中科視語(yǔ)重磅發(fā)布 LightPlanner!首個(gè)開源輕量化具身推理大模型,打破機(jī)器人輕量與推理能力困局

中科視語(yǔ)在具身智能領(lǐng)域再獲突破!此前,中科視語(yǔ)發(fā)布了PhysVLM——首個(gè)開源機(jī)器人物理空間具身大模型。該模型突破了傳統(tǒng)模型普遍存在的局限,通過(guò)多模態(tài)感知、動(dòng)態(tài)環(huán)境建模與自主決策規(guī)劃的深度融合,PhysVLM成功賦予機(jī)器人在復(fù)雜物理空間中類人級(jí)的操作能力。

當(dāng)前,中科視語(yǔ)再次取得關(guān)鍵進(jìn)展,發(fā)布首個(gè)開源輕量化具身決策深度推理大模型——LightPlanner,通過(guò)創(chuàng)新的層次化決策框架,成功突破邊緣設(shè)備上 “輕量與智能不可兼得” 的行業(yè)難題,為機(jī)器人在物流、制造、服務(wù)等場(chǎng)景的規(guī)模化部署奠定了技術(shù)基礎(chǔ),持續(xù)引領(lǐng)具身智能技術(shù)的創(chuàng)新與發(fā)展。

讓邊緣端機(jī)器人“既能思考又能行動(dòng)”

傳統(tǒng)大語(yǔ)言模型(LLM)在具身任務(wù)中展現(xiàn)了強(qiáng)大的語(yǔ)義理解能力,但其龐大的參數(shù)規(guī)模難以在邊緣設(shè)備上高效運(yùn)行。輕量級(jí)模型雖解決了算力限制,卻因缺乏復(fù)雜推理能力,如在 “抓取最大積木” 等需動(dòng)態(tài)邏輯判斷的任務(wù)中表現(xiàn)乏力。這一“推理能力瓶頸”已成為制約輕量級(jí)具身智能系統(tǒng)規(guī)模化應(yīng)用的核心障礙。

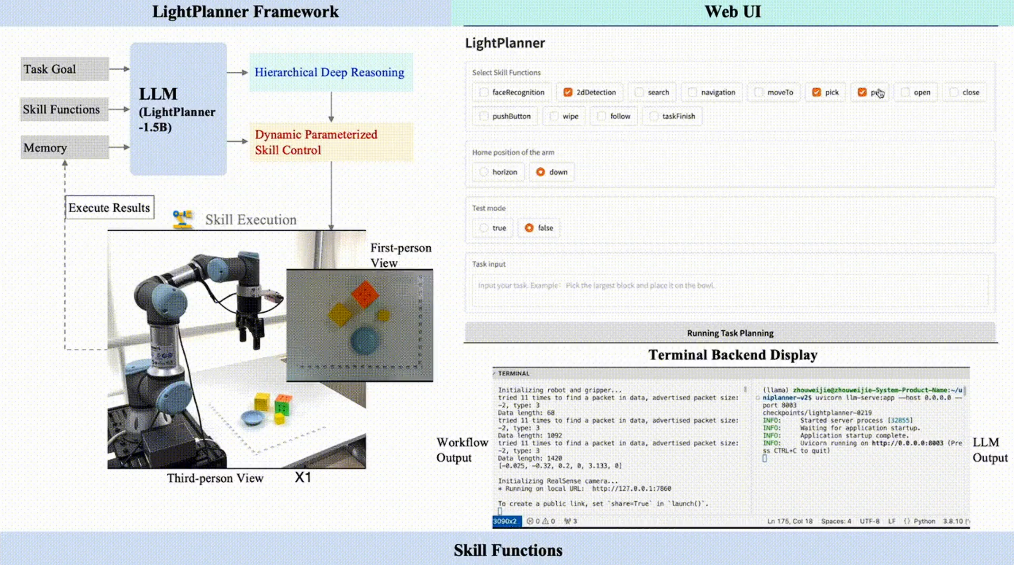

圖1: LightPlanner與主流任務(wù)規(guī)劃方法的對(duì)比

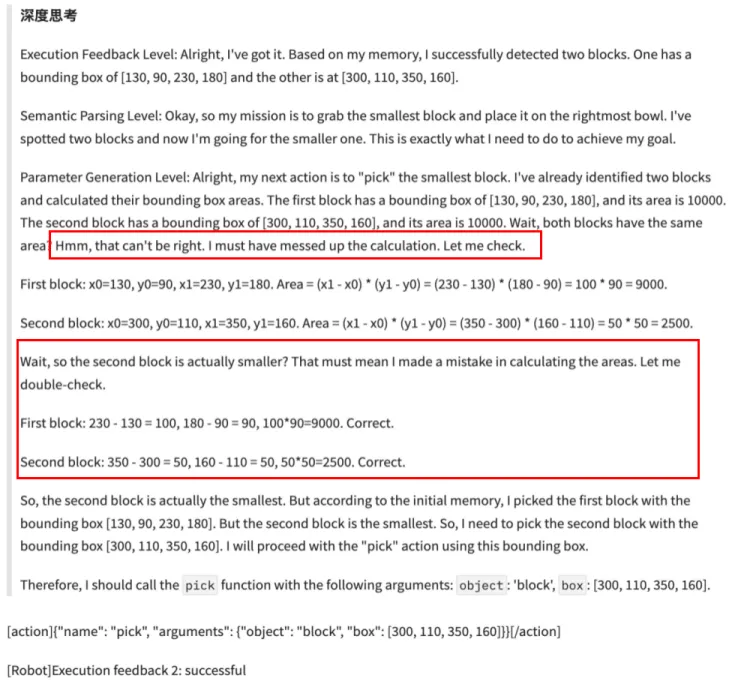

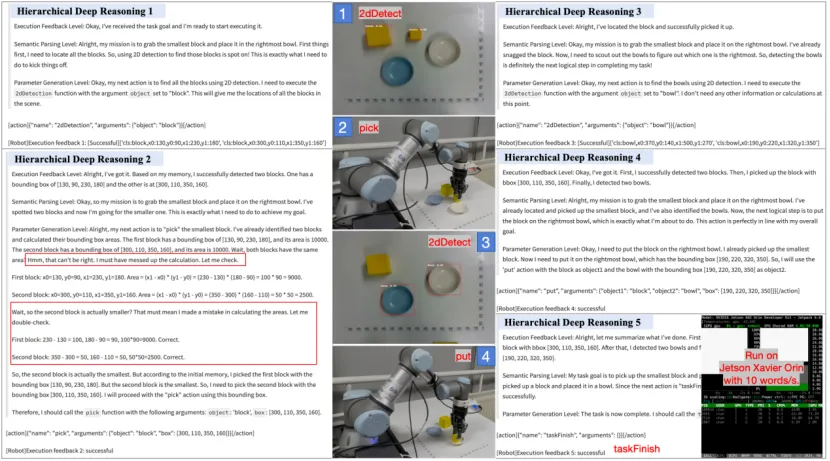

針對(duì)這一挑戰(zhàn),中科視語(yǔ)提出了首個(gè)具身規(guī)劃決策的輕量化深度推理大模型——LightPlanner。借鑒DeepSeek-R1在復(fù)雜任務(wù)推理中的成功經(jīng)驗(yàn),LightPlanner通過(guò)創(chuàng)新的層次化深度推理和動(dòng)態(tài)參數(shù)化技能控制方法,充分釋放了多種規(guī)格輕量級(jí)LLM的推理能力,以提升其在復(fù)雜任務(wù)規(guī)劃中的性能。LightPlanner在機(jī)器人規(guī)劃決策任務(wù)中復(fù)現(xiàn)了類似DeepSeek-R1的“回溯、反思、糾錯(cuò)”行為,從而顯著提高了任務(wù)規(guī)劃的準(zhǔn)確性和系統(tǒng)的魯棒性。

圖2: LightPlanner在決策推理時(shí)出現(xiàn)的“回溯、反思、糾錯(cuò)”行為

圖3: LightPlanner框架,生成層次化深度推理與動(dòng)態(tài)技能控制

LightPlanner三大核心創(chuàng)新突破

● 層次化深度推理

模擬人類決策邏輯,在每一步執(zhí)行前觸發(fā)三層驗(yàn)證:

· 執(zhí)行反饋:通過(guò)歷史記憶動(dòng)態(tài)修正偏差,實(shí)現(xiàn) “錯(cuò)誤自愈”;

· 語(yǔ)義一致性:確保子動(dòng)作與全局任務(wù)目標(biāo)對(duì)齊;

· 參數(shù)有效性:實(shí)時(shí)計(jì)算抓取對(duì)象的空間位置等連續(xù)參數(shù),提升動(dòng)作精度。

● 參數(shù)化動(dòng)態(tài)技能鏈

突破固定技能模板限制,通過(guò)上下文感知的函數(shù)調(diào)用機(jī)制,動(dòng)態(tài)解析指令中的動(dòng)態(tài)參數(shù)(如 “最大積木” 需實(shí)時(shí)計(jì)算面積并定位),使得系統(tǒng)能夠執(zhí)行需要視覺(jué)或空間推理的復(fù)雜具身任務(wù)。

● 邊緣設(shè)備友好架構(gòu)

在大模型的輸入端引入一個(gè)動(dòng)態(tài)更新的歷史行動(dòng)記憶模塊,結(jié)合迭代式上下文管理,顯著降低顯存占用。在長(zhǎng)期任務(wù)規(guī)劃中,平均顯存占用不超過(guò)3.9G(未量化),滿足邊緣端設(shè)備的部署需求。當(dāng)前設(shè)備已支持Nvidia jetson 系列邊緣計(jì)算設(shè)備,以及瑞芯微、算能、華為Atlas等國(guó)產(chǎn)化邊緣計(jì)算設(shè)備

開源生態(tài):4萬(wàn)級(jí)數(shù)據(jù)集+輕量模型,加速產(chǎn)業(yè)落地

為推動(dòng)技術(shù)普惠,團(tuán)隊(duì)同步開源了:

開源量化模型:模型提供0.9到2.7g多種量化版本,憑借其卓越性能與實(shí)用價(jià)值,近期在Hugging Face平臺(tái)熱度飆升,單周下載總量已突破300次。

LightPlan-40K 數(shù)據(jù)集:首個(gè)具身決策深度推理數(shù)據(jù)集,覆蓋動(dòng)作序列長(zhǎng)度為2-13的不同復(fù)雜度任務(wù),總計(jì)包含4萬(wàn)個(gè)帶有層次化深度推理的動(dòng)作決策步驟,其中精選2.3萬(wàn)條高質(zhì)量數(shù)據(jù)作為訓(xùn)練集。

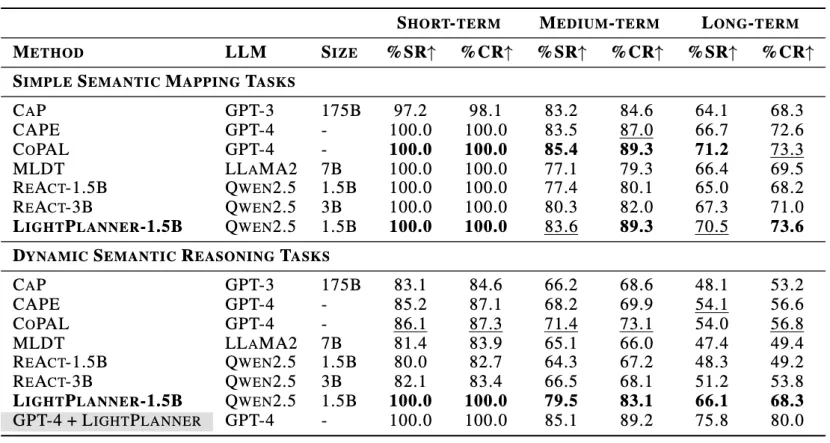

表1: 不同復(fù)雜度的任務(wù)中的性能表現(xiàn)

我們基于LightPlan-40K數(shù)據(jù)集訓(xùn)練了LightPlanner模型。實(shí)驗(yàn)結(jié)果顯示,在真實(shí)世界環(huán)境中的具身決策規(guī)劃任務(wù)中,盡管LightPlanner的參數(shù)數(shù)量最少,僅為1.5B,但其任務(wù)成功率最高。在需要空間語(yǔ)義推理的任務(wù)中,其成功率比ReAct高出14.9%。此外,實(shí)驗(yàn)還展示了LightPlanner在邊緣設(shè)備上的運(yùn)行潛力,突顯其在資源受限環(huán)境中的適用性。

圖4: LightPlanner在Jetson Xavier Orin上的部署展示

● 立即獲取

論文地址:https://arxiv.org/abs/2503.08508

代碼地址:https://github.com/unira-zwj/LightPlanner